Você já ouviu falar de racismo algorítmico? Pois é, a tecnologia também pode agir de maneira preconceituosa e prejudicar pessoas que não são brancas.

Dependendo de como esses algoritmos e sistemas foram programados para fazer escolhas, eles podem reforçar e perpetuar preconceitos raciais, o que leva a um tratamento injusto e a resultados desiguais para pessoas negras ou asiáticas.

“Uso o termo ‘racismo algorítmico’ para explicar como tecnologias e imaginários sociotécnicos em um mundo moldado pelo privilégio branco fortalecem a ordenação racializada de conhecimentos, recursos, espaço e violência em detrimento de grupos não brancos”, explica o pesquisador Tarcízio Silva, autor do livro “Racismo Algorítmico: inteligência artificial e discriminação nas redes digitais” em entrevista ao blog do CIEE-Fiocruz.

Para entender mais sobre o tema, continue lendo!

Leia também:

O que é racismo algorítmico?

Racismo algorítmico é a reprodução de desigualdades raciais por meio de sistemas automatizados, como algoritmos, inteligência artificial e plataformas digitais.

Mesmo sendo tecnologias aparentemente “neutras”, esses sistemas aprendem com dados históricos, decisões humanas e padrões sociais.

E aí que mora o problema: se esses dados carregam preconceitos, o sistema também vai reproduzi-los.

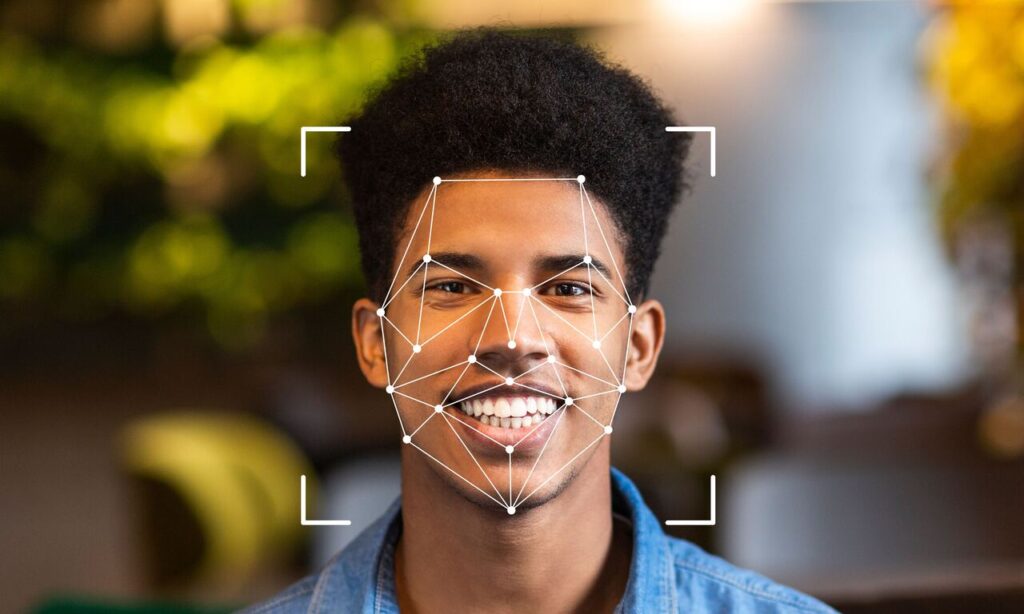

Isso significa que uma IA pode sugerir menos currículos de pessoas negras em processos seletivos, falhar em reconhecer rostos com tons de pele mais escuros ou dificultar o acesso de certos grupos a serviços digitais.

Como os algoritmos podem reproduzir o racismo existente na sociedade?

Algoritmos não nascem racistas, mas podem aprender a ser. Eles funcionam com base em dados e padrões históricos, que muitas vezes refletem desigualdades já existentes.

Se os dados de treinamento estão contaminados por preconceitos, o resultado final também estará.

Por exemplo: se um sistema de contratação é treinado com currículos de pessoas que foram historicamente privilegiadas (como homens brancos de determinada região), ele pode começar a “entender” que esse perfil é o ideal e descartar automaticamente candidatos com perfis diferentes.

O mesmo vale para reconhecimento facial, filtros de imagem, sistemas de crédito e outras ferramentas digitais. Ou seja, o algoritmo apenas repete o racismo que já existe na sociedade.

Por que o racismo algorítmico acontece?

Existem três grandes fatores por trás do racismo algorítmico:

- Falta de diversidade na tecnologia: a maioria das equipes que desenvolvem sistemas de IA e algoritmos ainda é composta majoritariamente por pessoas brancas. Isso significa que as experiências e necessidades de pessoas negras, indígenas ou asiáticas muitas vezes não são consideradas nos processos de desenvolvimento.

- Falta de transparência nos critérios usados: alguns algoritmos tomam decisões que nem os próprios desenvolvedores conseguem explicar direito. Sem saber como uma recomendação é feita, como uma triagem é realizada ou como uma pessoa foi rejeitada por um sistema, fica muito difícil identificar e corrigir.

- Ausência de leis e regulação eficazes: são poucos os países que têm regras claras sobre o uso ético e justo de algoritmos. Isso dificulta a responsabilização de empresas e governos por decisões enviesadas e, na prática, permite que injustiças se perpetuem no mundo digital.

Para enfrentar esse problema, especialistas defendem mais diversidade nas equipes técnicas, mais transparência nos algoritmos e, principalmente, o uso de princípios de justiça social no desenvolvimento tecnológico.

“Gosto muito da ideia de auditoria pública, com debates, testes, mapeamento de casos e de impactos, que sejam abertos pela própria sociedade”, explica Tarcízio Silva ao blog do CIEE-Fiocruz. “Assim, os impactos do racismo algorítmico podem ser demonstrados e a sociedade civil pode reagir.”

Quais os impactos do racismo algorítmico na sociedade?

O racismo algorítmico não é uma teoria distante, ele afeta a vida real de milhões de pessoas, muitas vezes de forma invisível.

Veja alguns exemplos dos impactos do racismo algorítmico na sociedade:

- Reconhecimento facial com falhas: sistemas usados por empresas, governos e aplicativos têm mais dificuldade em identificar corretamente rostos de pessoas negras. É o que gera abordagens policiais injustas, bloqueio de contas ou até negação de acesso a serviços.

- Filtros com viés estético: plataformas que “embelezam” imagens costumam clarear tons de pele ou afinar traços faciais, reforçando padrões racistas de beleza e apagando a diversidade dos rostos reais.

- Recomendações enviesadas: algoritmos de vagas de emprego, crédito bancário, habitação ou conteúdo online podem excluir, ou priorizar, pessoas com base em critérios que reproduzem discriminações históricas.

Quando se somam, criam barreiras adicionais para quem já enfrenta desigualdades fora do ambiente digital. E o mais grave: sem perceber, muita gente acredita que as decisões do algoritmo são neutras ou objetivas.

Quais são os tipos mais comuns de viés algorítmico?

Além do viés racial, existem diversos outros tipos de discriminação em algoritmos que podem ser reforçados por algoritmos:

- Viés de gênero: como sistemas que associam determinadas profissões apenas a homens ou mulheres, ou que oferecem anúncios diferentes com base no gênero.

- Viés social e econômico: algoritmos que favorecem pessoas com mais renda, escolaridade ou CEPs de áreas valorizadas.

- Viés etário: exclusão de pessoas mais velhas em sistemas de recomendação ou contratação.

- Viés religioso ou cultural: decisões automatizadas que desfavorecem nomes, roupas ou comportamentos associados a determinadas crenças.

- Viés de linguagem e aparência: como assistentes de voz que compreendem melhor certos sotaques ou sistemas que penalizam quem foge do “padrão estético” idealizado.

Quais casos reais evidenciam o racismo algorítmico?

Falar sobre racismo digital e algorítmico pode parecer abstrato até que você se depara com os exemplos reais. E eles são muitos.

A seguir, alguns dos casos que colocaram o tema em pauta:

Joy Buolamwini e o rosto “invisível”

Durante sua pesquisa no MIT, a cientista Joy Buolamwini descobriu que o software de reconhecimento facial que usava não detectava seu rosto. O motivo?

Ela é uma mulher negra. Para ser reconhecida, precisou vestir uma máscara branca.

A experiência virou tema do documentário Coded Bias (disponível na Netflix) e levantou o alerta sobre como a inteligência artificial pode excluir pessoas com tons de pele escuros, simplesmente porque não foi treinada para reconhecê-las.

CEOs brancos gerados por IA

Pesquisadores da Universidade de Leipzig, em parceria com a Hugging Face, testaram o DALL·E 2 (gerador de imagens por IA) e observaram um padrão.

Ao pedir imagens de “CEO”, 97% dos resultados mostravam homens brancos. Isso revela como até ferramentas criativas reproduzem estereótipos raciais e de gênero.

Vigilância desigual em Nova York

Um relatório da Anistia Internacional mostrou que bairros com maior população negra, latina e asiática em Nova York tinham mais câmeras de vigilância e, consequentemente, mais abordagens policiais.

Isso cria um ciclo de monitoramento e repressão racial alimentado por decisões automatizadas e injustas.

Como combater o racismo algorítmico?

Se os algoritmos podem perpetuar o racismo, eles também podem ser parte da solução. Mas isso não acontece sozinho.

Combater o racismo algorítmico exige ação coletiva, responsabilidade ética e mudanças estruturais no setor de tecnologia.

Veja alguns caminhos essenciais quando se quer combater o racismo algorítmico:

Diversidade nas equipes de tecnologia

Não dá para desenvolver sistemas justos se só um grupo está por trás do código. Incluir pessoas negras, indígenas, mulheres, pessoas trans e outras vozes sub-representadas nas equipes de dados e desenvolvimento é o primeiro passo.

Auditoria constante dos sistemas

Testar, mapear e revisar os impactos de algoritmos, na prática. Isso vale tanto para empresas privadas quanto para políticas públicas.

A ideia de uma “auditoria pública”, como defende o pesquisador Tarcízio Silva, permite que a sociedade civil participe ativamente, apontando falhas e exigindo melhorias.

Transparência na tomada de decisões algorítmicas

Muitos algoritmos são caixas-pretas. Ninguém sabe ao certo como escolhem um perfil para entrevista ou por que rejeitam um empréstimo.

Tornar esses critérios públicos é fundamental para reduzir injustiças e permitir a responsabilização quando há discriminação em algoritmos.

Regulação e leis específicas

Ainda estamos atrasados em termos de legislação que puna e previna o racismo digital. Projetos de lei que envolvam inteligência artificial e proteção de dados precisam incluir cláusulas claras sobre igualdade racial e direitos fundamentais.

Por que discutir racismo algorítmico é urgente para a sociedade?

A inteligência artificial e os algoritmos já fazem parte de decisões que impactam diretamente a vida das pessoas: da liberação de crédito ao acesso a serviços públicos, da seleção para vagas de emprego à vigilância policial.

E o problema é que essas decisões, muitas vezes, não são neutras.

Sem fiscalização adequada, os algoritmos podem reforçar desigualdades históricas e aprofundar exclusões que a sociedade tenta combater há décadas.

Pior: fazem isso de forma silenciosa, escondida sob a aparência de “eficiência” e “automatização”.

Além disso, a falta de regulamentação específica abre espaço para abusos. Empresas e governos podem usar sistemas enviesados sem prestar contas, e as pessoas afetadas nem sempre têm ferramentas para questionar ou recorrer.

Não se trata de uma crítica à tecnologia em si, mas sim de um alerta sobre como ela deve ser usada com responsabilidade, diversidade e justiça.

Como plataformas e empresas podem adotar tecnologia ética e inclusiva?

A adoção de tecnologias mais justas começa com uma decisão estratégica: colocar a equidade no centro do desenvolvimento.

Isso significa ir além da performance técnica e pensar no impacto social que cada sistema pode gerar.

Algumas boas práticas que empresas e plataformas podem seguir:

- Diversidade nas equipes: quanto mais plural for o time que projeta algoritmos, maior a chance de que diferentes vivências sejam consideradas e vieses sejam identificados logo no início.

- Testes e validação contínua: nenhum algoritmo é infalível. Por isso, toda empresa precisa revisar regularmente seu funcionamento, com auditorias internas e externas.

- Transparência: deixar claro como as decisões são tomadas e quais critérios são utilizados permite que usuários e especialistas acompanhem possíveis distorções.

- Uso de dados representativos: bancos de dados com recortes diversos ajudam a evitar generalizações injustas e falhas graves.

- Compromissos públicos com equidade: empresas que assumem posicionamentos claros e prestam contas regularmente ganham credibilidade e ajudam a pressionar o setor por avanços reais.

Quais ações o iFood tem realizado para combater o racismo algorítmico?

Para acolher e proteger, a empresa oferece a todos os entregadores parceiros suporte psicológico e jurídico gratuito em situações de discriminação, agressão física, ameaça ou violência sexual.

O iFood também adota uma política antidiscriminatória e, recentemente, ampliou suas diretrizes, reforçando o compromisso com um ambiente mais seguro e ético para entregadores, estabelecimentos parceiros, clientes e operadores logísticos.

Como medida adicional de segurança, há verificação de identidade por reconhecimento facial — procedimento autorizado pela LGPD para prevenir fraudes e garantir a segurança do titular no processo de identificação e autenticação.

O uso desses dados é exclusivo para essa finalidade, sob controles de proteção da informação, e não envolve qualquer análise de características raciais.

Só no primeiro ano, o canal recebeu mais de 19 mil denúncias válidas, com 90% resultando em sanções.